DeeperSense

Deep-Learning for Multimodal Sensor Fusion

Das Hauptziel von DeeperSense ist die signifikante Verbesserung der Fähigkeiten zur Umgebungswahrnehmung von Service Robotern, um deren Leistung und Zuverlässigkeit zu erhöhen, neue Funktionen zu erreichen und neue Anwendungen für die Robotik zu erschließen. DeeperSense verfolgt einen neuartigen Ansatz, um Künstliche Intelligenz bzw. datengetriebenes maschinelles Lernen / DeepLearning zu nutzen um die Funktionen von nicht-visuellen und visuellen Sensoren zu kombinieren, mit dem Ziel, ihre gemeinsame Fähigkeit der Umgebungswahrnehmung über die Fähigkeiten der einzelnen Sensoren hinaus zu verbessern. Als eines der anspruchsvollsten Anwendungsgebiete für Robotereinsätze und Umgebungswahrnehmung wählt DeeperSense die Unterwasserrobotik als Domäne um diesen Ansatz zu demonstrieren und zu verifizieren. Das Projekt implementiert DeepLearning-Lösungen für drei Anwendungsfälle, die aufgrund ihrer gesellschaftlichen Relevanz ausgewählt wurden und von konkreten Endanwender- und Marktbedürfnissen getrieben sind. Während des Projekts werden umfangreiche Trainingsdaten generiert. Die Algorithmen werden auf diesen Daten trainiert und sowohl im Labor als auch in umfangreichen Feldversuchen verifiziert. Die trainierten Algorithmen werden so optimiert, dass sie von der On-Board-Hardware der Unterwasserfahrzeuge genutzt werden können um autonomes Roboterverhalten in Echtzeit zu unterstützen . Sowohl die Algorithmen als auch ein Teil der Trainingsdaten werden über Online-Datenbanken, die in den europäischen Forschungsinfrastrukturen eingebettet sind, öffentlich zugänglich gemacht. Das DeeperSense-Konsortium beinhaltet erfahrene Experten für Robotik und Meeresrobotik, künstliche Intelligenz und Unterwassersensorik. Die Forschungs- und Technologiepartner werden durch Endanwender aus den drei Anwendungsbereichen ergänzt. Die Verwertungsstrategie von DeeperSense hat unter anderem das Ziel, die Lücke zwischen den europäischen Robotik- und KI-Gemeinschaften zu schließen und so die europäische Wissenschaft und Technologie zu stärken.

| Laufzeit: | 01.01.2021 bis 31.12.2023 |

| Zuwendungsempfänger: | Deutsches Forschungszentrum für Künstliche Intelligenz GmbH |

| Fördergeber: | Europäische Union |

| Förderkennzeichen: | H2020-ICT-2020-2 ICT-47-2020 Project Number: 101016958 |

| Webseite: | https://www.deepersense.eu |

| Partner: |

Universitat de Girona |

| Anwendungsfelder: |

Unterwasserrobotik

SAR- & Sicherheitsrobotik |

| Verwandte Projekte: |

TRIPLE-nanoAUV 1

Selbstlokalisierung und Perzeption eines miniaturisierten autonomen Unterwasserfahrzeuges zur Erforschung subglazialer Seen

(09.2020-

06.2023)

Mare-IT

Informationstechnologie für maritime Anwendungen

(08.2018-

11.2021)

REMARO

Reliable AI for Marine Robotics

(12.2020-

11.2024)

|

| Verwandte Robotersysteme: |

DAGON

Getaucht verbleibendes AUV

|

Projektdetails

Die Anwendbarkeit von autonomen Robotern in der realen Welt (z. B. für Inspektion und Wartung) hängt stark von ihren Wahrnehmungsfähigkeiten ab. Nur wenn ein Roboter in der Lage ist, seine Umgebung auch unter schierigen Umgebungsbedingungen (schmutzig, dunkel, trübe, beengt) wahrzunehmen, kann er zuverlässig arbeiten, ohne den Erfolg der Mission zu gefährden oder gar menschliche Operator in der Nähe zu gefährden.

Visuelle Sensorik (z. B. Kameras) ist eine der häufigsten Wahrnehmungstechniken, die in der Robotik für Aufgaben wie autonome Navigation und Manipulation, Kartierung und Objekterkennung eingesetzt werden. Aber obwohl Kameras und andere visuelle Sensoren prinzipiell in der Lage sind, sehr dichte und detaillierte Informationen über die Umgebung des Roboters zu liefern, hängt ihre Leistung stark von den Umgebungslicht- und Sichtbedingungen ab und kann sich drastisch verschlechtern, wenn diese Bedingungen nicht optimal sind (z. B. in dunklen oder verschwommenen Umgebungen). Wenn Entscheidungs- und Steuerungsalgorithmen jedoch stark von den Daten dieser Sensoren abhängen, können die negativen Auswirkungen auf die Praxistauglichkeit eines autonomen Roboters erheblich sein. Es ist ein häufiges Phänomen, dass autonome Roboter, die im Labor (d.h. unter kontrollierten Licht- und Sichtbedingungen) perfekt funktionieren, kläglich versagen, sobald sie der realen Welt (d.h. dynamischen, unvorhersehbaren und suboptimalen Licht- und Sichtbedingungen) ausgesetzt werden.

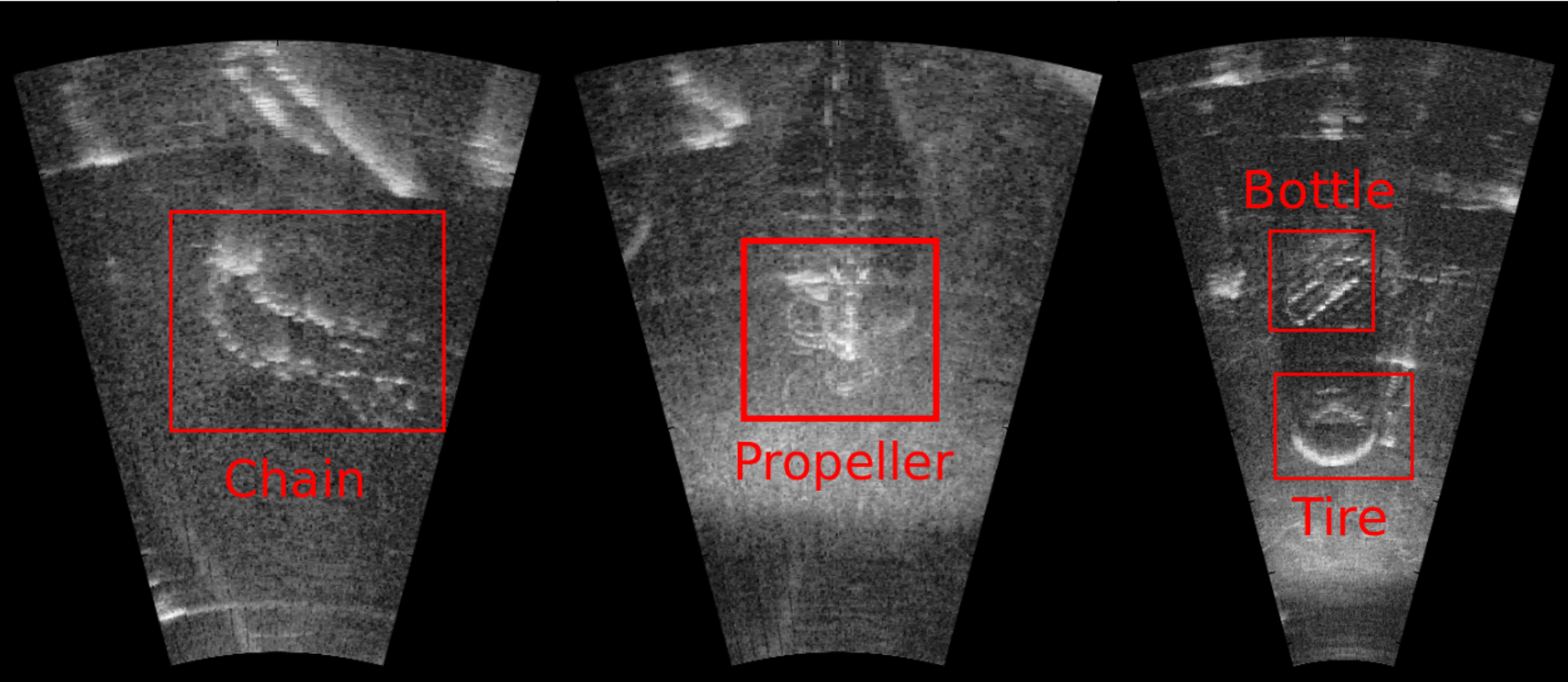

Auf der anderen Seite sind alternative nicht-visuelle Sensortechniken entstanden, die von den Sensorfähigkeiten einiger Tierarten inspiriert wurden. Beispiele hierfür sind Akustik, Magnetorezeption oder Thermorezeption. Akustische Sensorik wird beispielsweise nicht durch schlechte Sicht- und Lichtverhältnisse beeinträchtigt und kann für Entfernungsmessungen oder sogar bildähnliche Daten verwendet werden. Akustische Sensoren (z. B. Ultraschall) werden in terrestrischen Anwendungen eingesetzt, aber in Form von SONAR (SOund Navigation and Ranging) vor allem in marinen (Unterwasser-) Anwendungen, wo Faktoren wie Farbabsorption, optische Verzerrung, Spiegeleffekte, schlechte Lichtverhältnisse und vor allem die geringe Sichtbarkeit in trüben Gewässern die Möglichkeiten der visuellen Abtastung erheblich einschränken. Auf der anderen Seite sind die Hauptmängel von akustischen und anderen nicht-visuellen Erfassungsmethoden ihre geringe räumliche Auflösung im Vergleich zu visuellen Sensoren und die Tatsache, dass sie, besonders in dynamischen Umgebungen, typischerweise unter einem geringen Signal-Rausch-Verhältnis leiden. Abbildung 1-1 zeigt drei typische Sonarbilder mit Objekten, die selbst für ein geschultes menschliches Auge schwer zu unterscheiden und zu klassifizieren sind. Im Allgemeinen erschweren diese Unzulänglichkeiten den Einsatz nicht-visueller Erfassungsmethoden für die Roboterwahrnehmung oder sogar für menschliche Bediener von ferngesteuerten Robotern.

Es ist jedoch möglich, die Unzulänglichkeiten der nicht-visuellen Wahrnehmung zu mildern, indem solche Sensoren in die Lage versetzt werden, latente Merkmale von anderen Wahrnehmungsmodalitäten (einschließlich der visuellen) zu erlernen und somit Wissen zwischen Sensoren zu übertragen, sowohl über High-Level-Merkmale als auch über Low-Level-Messungen. Mit dem Aufkommen datengetriebener KI-Techniken wie Deep Learning für die Bilderkennung und die Verarbeitung natürlicher Sprache stehen leistungsfähige Werkzeuge zur Verfügung, um Informationen zu extrahieren, die in (Sensor-)Daten eingebettet sind, indem direkt auf Input-Output-Beziehungen geschlossen wird.

Als geeignetes Anwendungsgebiet für die Demonstration des DeeperSense-Konzepts wurde die Marine- und Unterwasserdomäne gewählt, da sie den Prototyp einer extrem rauen und (aus Sicht der Sensorik) schwierigen Umgebung darstellt. Der Fokus im Projekt liegt auf visuellen und akustischen Sensoren. Das allgemeine Konzept des intersensorischen Lernens ist jedoch auf alle robotischen Anwendungsdomänen und viele Sensormodalitäten anwendbar.

Das DeeperSense-Konzept wird in drei Anwendungsfällen demonstriert. Diese Anwendungsfälle wurden sowohl aufgrund ihrer Bedeutung für die Weiterentwicklung des Stands der Technik in der Robotik als auch aufgrund ihrer gesellschaftlichen Relevanz ausgewählt.

USECASE I: Hybrides AUV für die Sicherheitsüberwachung von Tauchern:

Bei vielen Unterwasseranwendungen im Zusammenhang mit Inspektion & Wartung, Notfallmaßnahmen und anderen Unterwasseroperationen spielen professionelle Taucher immer noch eine wichtige Rolle. Während selbst das normale professionelle/industrielle Tauchen von Natur aus gefährlich ist und gut geplant und überwacht werden muss, sind Sicherheitsaspekte beim professionellen Tauchen im Zusammenhang mit Katastrophenschutz und Notfallmaßnahmen noch wichtiger. Hier kann im Vergleich zum normalen Industrietauchen nur eine sehr begrenzte Zeit für die Planung zur Verfügung stehen, während die Taucher komplexe Aufgaben wie Schweißen, Reinigen und Trümmerbeseitigung durchführen müssen.

Die Taucher müssen diese Tätigkeiten typischerweise in einer komplexen Umgebung mit vielen (künstlichen) Objekten und Hindernissen durchführen, wie z. B. Häfen, Piers, Industriebecken und Kanälen. Dies erschwert die Navigation und Selbstlokalisierung. Außerdem, selbst wenn die Sicht zu Beginn des Tauchgangs gut ist, führen fast alle der oben genannten Aktivitäten zu einer Erhöhung der Wassertrübung, was regelmäßig zu White-Out-Situationen führt. Abbildung 1-2 zeigt einige Tätigkeiten, die Trübungen in der Umgebung des Tauchers verursachen: die Verwendung eines Pressluftbohrers (A), das Bohren in ein Stück Holz (B) oder Pumpvorgänge (C).

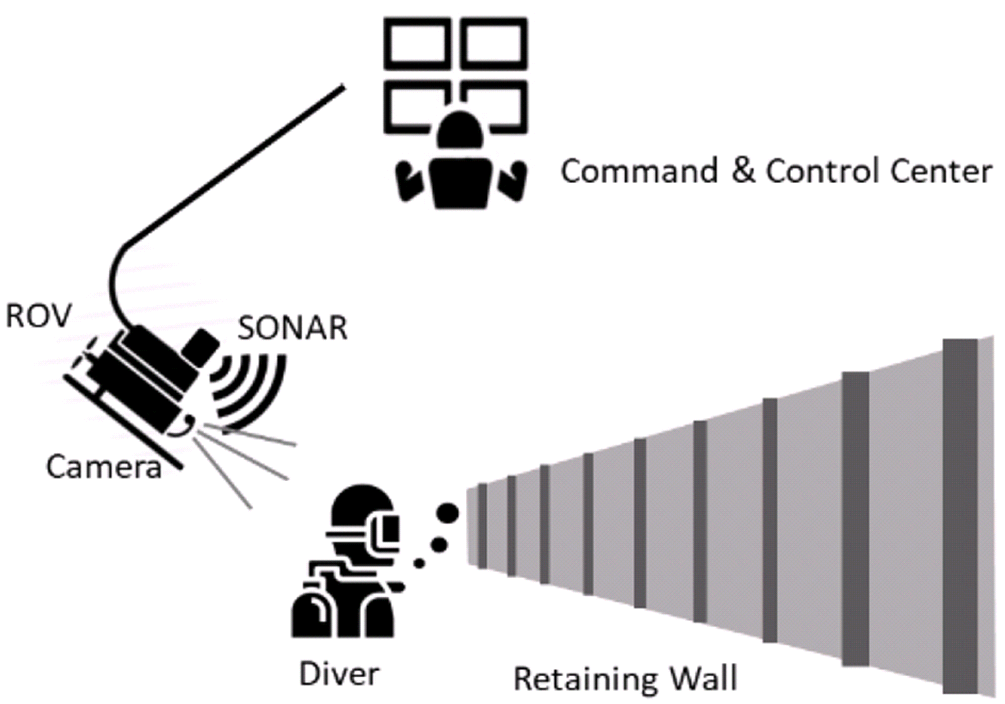

In solchen trüben Sichtverhältnissen ist es, wie in normalen Arbeitssituationen, für die Sicherheit des Tauchers unerlässlich, dass er von einem Bediener in der Einsatzzentrale, der einen Überblick über die Situation hat und weiß, wo sich der Taucher befindet, was er tut und wohin er sich als Nächstes begeben soll, geführt und angewiesen wird. Zum Stand der Technik gehört eine Ego-Perspektiv-Kamera direkt am Helm. Zusätzlich werden manchmal ferngesteuerte Fahrzeuge (Remotely Operated Vehicles, ROVs) eingesetzt, um den Taucher aus der Perspektive einer dritten Person zu beobachten und zu instruieren (Abbildung 1-3). Unter perfekten Sichtbedingungen mag dies ausreichen, aber zur Überwachung schwerer Unterwasserarbeiten (die eine erhebliche Trübung erzeugen) sind sowohl die Anzugkamera als auch die ROV-Kamera nur von begrenztem Nutzen.

In DeeperSense wird ein hybrides AUV mit einem Sonarsensor ausgestattet, das von einer HD-Kamera gelernt hat, wie man niedrig aufgelöste Sonarsignale eines Tauchers zuverlässig interpretiert und in eine visuelle Ansicht umwandelt. Dieses visuelle Bild des Tauchers wird dann vom menschlichen Bediener im Kontrollzentrum verwendet, um die Aktionen, den Zustand und die Position des Tauchers zu bewerten, sowie vom Follow-me-Steuerungsalgorithmus des hybriden AUVs gesteuert, um einen konstanten Abstand zum Taucher zu halten (Abbildung 3). Da sich diese Anwendung nur auf die akustischen SONAR-Daten stützt, wird sie nicht durch schlechte Sicht, Dunkelheit oder andere optische Störungen beeinflusst.

Der Anwendungsfall wird durch das THW als Endanwender vorangetrieben und mit echten Tauchern in einer Übungsanlage unter ständig abnehmenden Sichtbedingungen demonstriert.

USECASE II: Erkundung und Überwachung komplexer benthischer Umgebungen, z. B. Korallenriffe:

Die Erkundung komplexer Unterwasserstrukturen (z. B. eines Korallenriffs) mit einem autonomen Unterwasserfahrzeug (AUV) erfordert fortschrittliche Fähigkeiten zur Umgebungswahrnehmung und Navigation, insbesondere in Bezug auf die Hindernisvermeidung (OA). OA für AUVs hat an Bedeutung gewonnen, da der Einsatz von AUVs in einem breiten Spektrum wissenschaftlicher, kommerzieller und militärischer Anwendungen, wie z. B. archäologische Untersuchungen, ökologische Studien und Überwachung, Wrackerkundung, Inspektion von Unterwassergeräten und Aufspüren von Unterwasserminen, schnell zunimmt.

Sowohl visuelle Sensoren (Kameras) als auch akustische Sensoren (Sonar) können verwendet werden, um Hindernisse unter Wasser zu erkennen. Akustische Sensoren, die am häufigsten für OA in Unterwasseranwendungen eingesetzt werden, sind jedoch im Nahbereich (< 5 m) aufgrund von Störgeräuschen und Mehrwegephänomenen nicht effektiv. Darüber hinaus können akustische Sensoren nur 2D-Informationen über die Umgebung liefern, statt einer vollständigen 3D-Struktur, mit begrenzter Auflösung und Details. Akustische OA ist daher in komplexen Unterwasserumgebungen, die ein feinfühliges Manövrieren erfordern, wie z. B. künstliche Strukturen, Wracks, Canyons oder Riffe, fast nutzlos, und Standard-OA-Schemata sind sehr einfach und weisen das AUV in der Regel nur an, aufzusteigen, bis das Hindernis vom Sensor verschwindet.

Optische OA, auf der anderen Seite, steckt noch in den Kinderschuhen für Unterwasseranwendungen, mit nur wenigen akademischen Versuchen in klarem Wasser und einfachen Szenen, aber keinen kommerziellen Produkten. Dies liegt vor allem an der schlechten Sichtbarkeit und dem geringen Kontrast in optischen Unterwasserbildern, die zu einem sehr begrenzten Abbildungsbereich führen. Dennoch wäre die optische OA eine bessere Lösung für die Nahbereichs-OA und Navigation. Darüber hinaus sind Kameras viel billiger und kleiner als Sonarsensoren. Die Verwendung von Kameras anstelle von Sonaren würde effizientere und kostengünstigere Fahrzeuge unterstützen und schließlich die Entwicklung und den Einsatz von Fahrzeugschwärmen zu vertretbaren Kosten ermöglichen.

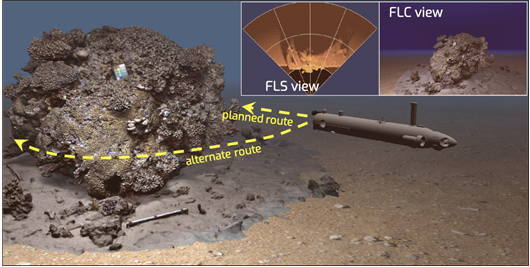

In DeeperSense wird ein neuartiges visuelles OA-System entwickelt, um heikle robotergestützte Unterwassermissionen, wie z.B. die Untersuchung komplexer Unterwasserumgebungen, zu erleichtern. Das visuelle OA-System wird in der Lage sein, die normalen Grenzen der visuellen Sensoren zu überwinden, indem es Merkmale von einem vorwärts gerichteten Sonar (FLS) lernt.

Das System wird in ein AUV integriert und zur Erkundung eines Korallenriffs im Roten Meer eingesetzt. Das neue OA-System wird es dem AUV ermöglichen, direkt durch das Korallenriff zu navigieren, anstatt weit über dem Riff bleiben zu müssen, wie es derzeit das Standardverfahren ist.

Die Erkundung eines Korallenriffs wurde als Anwendungsfall gewählt, weil Korallenriffe zu den wichtigsten marinen Lebensräumen gehören. Sie nehmen nur 0,1 % der Fläche des Ozeans ein, beherbergen aber 25 % aller marinen Arten auf dem Planeten. Die meisten riffbildenden Korallen sind koloniale Organismen aus dem Stamm der Nesseltiere (backscatter). Durch ihr Wachstum entstehen epische Strukturen, die vom Weltraum aus gesehen werden können. Diese Strukturen beherbergen nicht nur einige der vielfältigsten Ökosysteme der Welt, sondern ermöglichen auch die Bereitstellung von wertvolle Dienstleistungen und Gütern wie Küstenschutz, Lebensraumerhaltung, Fischprodukten, Erholung und Tourismus. Jüngste Schätzungen gehen davon aus, dass Korallenriffe jedes Jahr Güter und Dienstleistungen im Wert von fast 30 Milliarden US-Dollar liefern, einschließlich des mit Korallenriffen verbundenen Tourismus. Darüber hinaus haben Korallen aufgrund ihrer Unbeweglichkeit ein Arsenal an chemischen Substanzen entwickelt, die ein großes medizinisches Potenzial besitzen. Die Ökosysteme der Korallenriffe haben in den letzten Jahrzehnten einen massiven Rückgang erlitten, was zu einer ökologischen Krise der Meere geführt hat. Heute sind die Korallenriffe durch den Klimawandel und anthropogenen Stress stark bedroht. Die Kartierung von Korallenriffen liefert wichtige Informationen über eine Reihe von Riffeigenschaften, wie z.B. die Gesamtstruktur und Morphologie, die Häufigkeit und Verteilung lebender Korallen sowie die Verteilung und Art der Sedimente.

Daher sind erschwingliche AUVs, die die Umweltüberwachung dieses empfindlichen Ökosystems verbessern können, sehr im Interesse des Endnutzers, der Israel Nature and Parks Authority (INPA).

USECASE III: Multisensor-Kartierung des Meeresbodens und Interpretation für die Geophysik:

Hochauflösende Karten des Meeresbodens mit den topografischen Merkmalen, dem Bodentyp, den Lebensräumen der benthonischen Lebensformen und anderen Merkmalen, die korrekt identifiziert und klassifiziert wurden, sind die Grundlage für die wissenschaftliche Erforschung, die Umweltüberwachung und die wirtschaftliche Erschließung der Ozeane.

Heutzutage werden Vermessungen zur Erstellung solcher Karten typischerweise von Schiffen aus durchgeführt, wobei Side-Scan-Sonare und Fächerecholote eingesetzt werden. Sowohl die Tiefenmessungen als auch der akustische Rücklauf (Backscatter) der Sonare werden für die Interpretation herangezogen, die manuell und offline von einer Gruppe von Experten für Meeresgeologie oder -biologie durchgeführt wird. Zur Unterstützung der Interpretation werden Videoproben genommen, um eine visuelle Überprüfung der Eigenschaften des Bodens zu ermöglichen und somit eine Groundtruth für die Interpretation zu haben. Aufgrund der begrenzten Reichweite und der eingeschränkten Einsatzbedingungen der optischen Kameras unter Wasser werden solche Videoproben nur über kleine Bereiche erfasst und sind daher nicht repräsentativ für die viel größeren Bereiche, die typischerweise von den akustischen Sensoren abgedeckt werden.

Es besteht ein dringender Bedarf, diese Art von Vermessungen mit autonomen Roboterplattformen (AUVs) durchzuführen, bei denen die Erfassung und die Missionsplanung miteinander verbunden sind, um das Vermessungsmuster während der Fahrt an das vorgefundene Terrain anzupassen. Wenn AUVs großflächige akustische Kartierungen mit integrierter benthischer Klassifizierung durchführen können, führt dies zu erheblichen Kosteneinsparungen bei den Vermessungsarbeiten. Es wird auch zu einer besseren Charakterisierung des Benthos beitragen und damit zu einer fundierteren Entscheidungsfindung in Bezug auf die Planung von Eingriffen oder die Überwachung menschlicher Einflüsse.

In DeeperSense werden fortschrittliche Techniken des maschinellen Lernens eingesetzt werden, um eine Multisensor-Fusion verschiedener Quellen zu ermöglichen, hauptsächlich von Seitensichtsonaren, aber auch von Fächerecholoten. Optische Bilder werden als weitere Schicht für Training, Klassifizierung und Benchmarking verwendet, mit dem übergeordneten Ziel, bis zum Ende des Projekts eine genaue Charakterisierung des Meeresbodens mit einem AUV und ohne optische Bilder zu ermöglichen.

Die Lösung wird auf einer oder mehreren der vielen Vermessungsmissionen, die der Endnutzer Tecnoambiente (TA) jedes Jahr durchführt, validiert und demonstriert. Die entwickelten Methoden werden auch mit Daten demonstriert, die von den im Konsortium verfügbaren AUVs erfasst wurden.

Videos

DeeperSense: Lernen für multimodale Sensorfusion

Das Hauptziel von DeeperSense ist die Verbesserung der Unterwasser-Sensorik durch die Anwendung von DeepLearning-Methoden, um Daten von Sensoren zu fusionieren, die unterschiedliche Erfassungsmodalitäten verhindern. Die Rolle des DFKI in diesem Projekt besteht darin, Methoden zu trainieren, die eine Assoziation zwischen visuellen Sensoren wie RGB-Kameras und Laserscannern und akustischen Flugzeitsensoren wie vorwärtsgerichteten Sonaren (FLS) lernen. Das Ziel ist es, die trainierten Modelle einzusetzen, um visuell-ähnliche Bilder zu erzeugen, die nur akustische Daten verwenden, um die Überwachung von Tauchern bei schlechten Sichtverhältnissen zu unterstützen.

DeeperSense: Treffen Sie das Konsortium

Projektkoordinator Dr. Thomas Vögele vom Deutschen Forschungszentrum für Künstliche Intelligenz gibt eine kurze Einführung in das Projekt DeeperSense und die Versuche in der Maritimen Explorationshalle, die gemeinsam mit der Bundesanstalt Technisches Hilfswerk (THW) und der Kraken Robotik GmbH durchgeführt wurden.